Forschende der Hochschule Harz schicken ChatGPT ins Wissensduell und machen Künstliche Intelligenz für Laien erklärbar

Künstliche Intelligenz (KI) ist noch immer eine Art Blackbox und bleibt nach wie vor ein Stück weit undurchsichtig. Maschinen schreiben Texte, beantworten Sachfragen und fassen komplizierte Inhalte zusammen – doch wie funktioniert das alles? Rein technisch gesehen stecken hinter den Systemen – in Fachkreisen als große Sprachmodelle bezeichnet – dem menschlichen Gehirn ähnliche, künstliche neuronale Netze, die mit Mustererkennung und Algorithmen arbeiten. Für den ‚normalen‘ Nutzer sind solche fachspezifischen Betrachtungen jedoch kaum greifbar. Deshalb gehen zwei Forschende der Hochschule Harz einen anderen Weg. Sie zeigen, dass das wohl bekannteste Modell ChatGPT selbst menschenähnliche Argumente und Erklärungen vorbringen kann. Im direkten Vergleich mit dem Menschen liefern die Forschenden verständliche Antworten und machen KI erklärbar.

„KI-Systeme werden immer zuverlässiger, doch wie genau sie dazulernen und was sie für ein zielführendes Training benötigen, ist für uns noch immer nicht bis ins letzte Detail nachvollziehbar“, sagt Prof. Dr. Frieder Stolzenburg, der seit vielen Jahren im Bereich Künstliche Intelligenz und Wissensbasierte Systeme forscht. „175 Milliarden Parameter – das menschliche Gehirn hat übrigens nur gut halb so viele Nervenzellen – arbeiten im Hintergrund. Das ist unvorstellbar groß, sodass man das Konstrukt kaum durchschauen kann. Wir wollen aber wissen, warum welche Ergebnisse herauskommen. Wie bringt man also Transparenz hinein?“, beschreibt er seinen Forschungsantrieb.

Die gängige Forschung betrachte dabei bisher nur die technischen Komponenten. „Wie beim Gehirnscan können auch in KI-Systemen die aktiven neuronalen Komponenten sichtbar gemacht werden“, erklärt der Prorektor für Forschung und Chancengleichheit. „Wir wollten aber eine auch für Laien nachvollziehbare Erklärung der KI-Systemantworten suchen. Deshalb haben wir einfach das KI-System selbst gefragt, warum es bestimmte Antworten gegeben hat. Das unterscheidet uns von anderen Forschungsansätzen.“

An seiner Seite forscht seit rund einem Jahr Stefanie Krause. Die 28-Jährige lehrt am Fachbereich Automatisierung und Informatik und ist am Aufbau des einzigartigen kooperativen Bachelor-Studiengangs „AI Engineering – Künstliche Intelligenz in den Ingenieurwissenschaften“ beteiligt. „ChatGPT ist ein Tool, das mittlerweile von vielen Menschen genutzt wird, die die dahinter liegenden technischen Details nicht verstehen können oder wollen. Uns ist es daher wichtig, Erklärungen von KI-Antworten in leicht verständlicher, natürlicher Sprache zu generieren, damit Nutzer, die keine KI-Experten sind, trotzdem ein Verständnis für die Technologie entwickeln können“, betont sie. Und das sei sehr wichtig, wie die Ergebnisse zeigen. Denn nicht immer liegt ChatGPT richtig und kann unaufgeklärte Nutzer damit auch in die Irre führen, sagt sie.

„Wir haben in unserer Untersuchung zunächst Fragen aus elf sogenannten Benchmark-Datensätzen entnommen. Das sind von der Wissenschaft zur Verfügung gestellte Sammlungen von Fragen mit mehreren vorgegebenen Antwortmöglichkeiten“, erklärt Stefanie Krause. Einen Textabschnitt mit einem sinnvollen Abschlusssatz vervollständigen, die Gefühle einer Person in einer beschriebenen Situation einschätzen, physikalische Zusammenhänge erkennen oder Behauptungen auf Richtigkeit überprüfen – die Themengebiete und Arten der Fragestellungen waren vielfältig.

„Je 30 Fragen pro Datensatz haben wir ChatGPT beantworten lassen. Aber wir haben uns nicht allein mit der Antwort zufrieden gegeben. Wir haben den Chatbot auch begründen lassen, warum er diese Antwort als die richtige ansieht.“ Und ChatGPT hat geantwortet, wenn auch in unterschiedlicher Qualität. Herausgekommen sind laut Stefanie Krause einfachste Erklärungen wie ‚Die Antwort ist richtig, weil sie richtig ist.‘ bis hin zu komplexeren, mehrsätzigen Begründungen, beispielsweise bei der Beschreibung physikalischer Prozesse. „Gemeinsam hatten alle Antworten jedoch, dass die Begründung ausschließlich auf die ausgewählte Antwort ausgerichtet war. ChatGPT hat zu wenig die anderen Antwortmöglichkeiten, zum Beispiel über ein Ausschlussverfahren oder andere logische Argumente, in die Entscheidung einbezogen.“

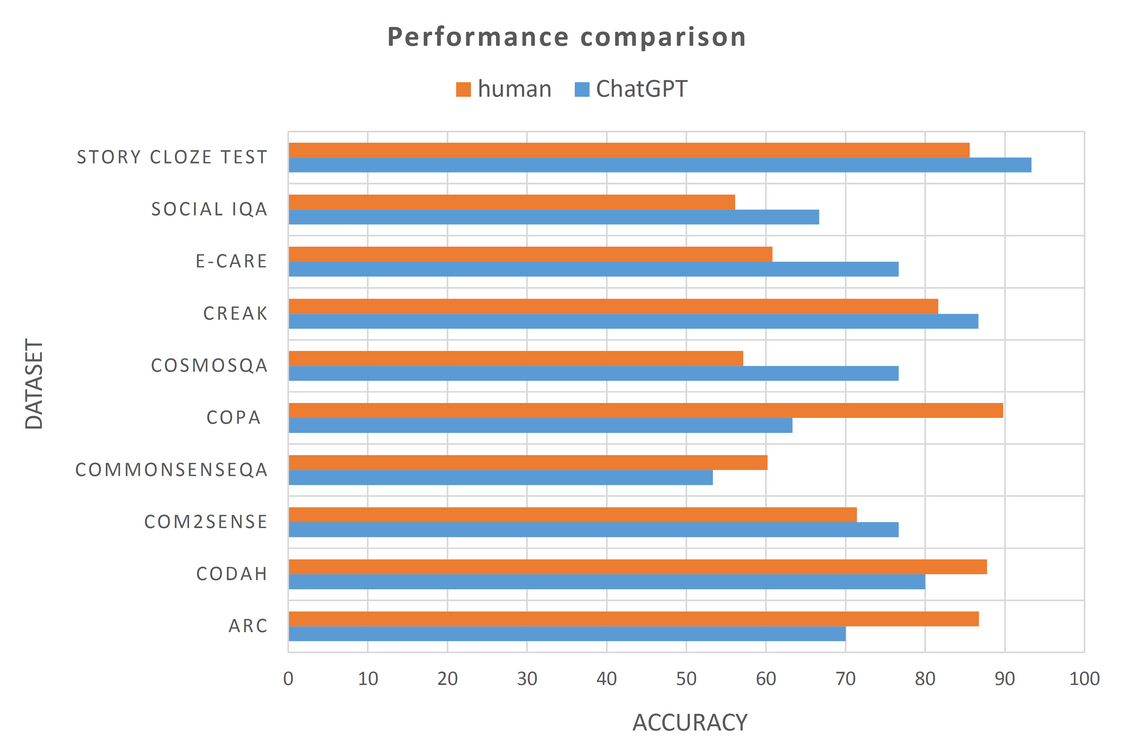

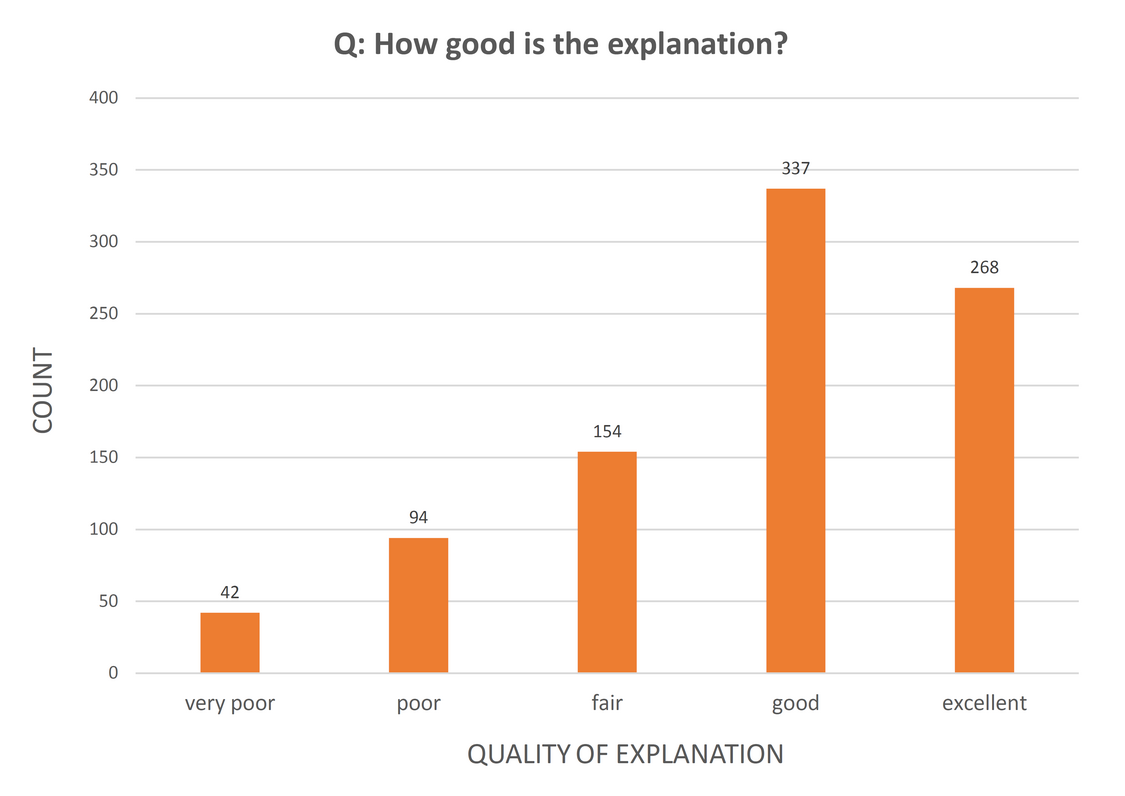

In einem zweiten Schritt haben die Forschenden eine kleine Auswahl an Fragen – je zwei pro Datensatz, wobei der medizinische Fragenblock aufgrund des notwenigen Fachwissens ausgeschlossen wurden – knapp 50 Studierenden gestellt. „Dabei haben wir festgestellt, dass ChatGPT die Fragen im Durchschnitt ähnlich richtig beantwortet hat wie die Menschen“, verrät Stefanie Krause. Einen klaren Sieger des Wissensduells gebe es demnach nicht, auch wenn es bei der Treffsicherheit je Themengebiet Unterschiede gebe. Spannender sei jedoch das Ergebnis einer weiteren Befragung. Den Studierenden wurden jeweils auch die Antworten samt Begründungen gezeigt, die der Chatbot gegeben hat. Sie sollten einschätzen, wie gut die Erklärung ist. „68 Prozent der Teilnehmenden fanden die Begründungen von ChatGPT mindestens gut oder sogar exzellent – selbst, wenn die Antwort falsch war“, zeigt sich die Forscherin überrascht.

„Das birgt natürlich eine große Gefahr. Man sollte sich auf keinen Fall darauf verlassen, dass die Antworten immer richtig sind.“ ChatGPT sei dennoch nicht komplett zu verteufeln. „Das Tool kann unbedenklich genutzt werden, wenn man sich grundlegend über ein Thema informieren und einen Überblick bekommen möchte, eine Zusammenfassung eines sehr langen Texts benötigt oder Hilfe bei textlichen Umformulierungen sucht“, schätzt Stefanie Krause ein. „Kritisch ist es jedoch, wenn es für wissenschaftliche Arbeiten genutzt wird, weil für den Nutzer nicht nachvollziehbar ist, aus welcher Quelle die Informationen stammen und wie zuverlässig sie sind.“

Für das Forschungsduo sei es wiederum für das Verständnis des KI-Systems sehr wichtig gewesen, zu sehen, wie der Chatbot antwortet und als wie hilfreich Erklärungen von den Studierenden eingestuft wurden. Das könne Grundlage für weitere Forschungen sein. „ChatGPT wird nicht auf dem Stand bleiben, das System wird sich weiterentwickeln. Vielleicht werden dazu auch unsere Erkenntnisse genutzt, beispielsweise zur Art der Fragestellungen, die noch nicht so treffsicher beantwortet werden und deshalb besser trainiert werden müssen“, sagt Stefanie Krause.

In Fachkreisen haben Frieder Stolzenburg und sie ihre Ergebnisse jüngst bei einem Begleitworkshop im Rahmen der ECAI – der Europäischen Tagung für Künstliche Intelligenz – in Krakau (Polen) vorgestellt. „Wir haben sehr viel positives Feedback von anderen Forschenden bekommen. Was wir vorgestellt haben, nämlich nicht nur ins Innere zu schauen, sondern eine Erklärung direkt vom KI-System einzufordern, sei eine wichtige und bisher kaum bis gar nicht betrachtete Perspektive“, freut sich Stefanie Krause über die Rückmeldung aus dem Kollegenkreis. Der Vortrag sei für die IHK-Forschungspreisträgerin zudem ein großer erster Baustein auf dem Weg zur Doktorarbeit. Sie strebt eine Promotion am Promotionszentrum Ingenieurwissenschaften und Informationstechnologien an der Hochschule Harz im Bereich ‚Erklärbare KI‘ an.

30.10.2023

Autor/Autorin: Karoline Klimek

Fotograf/Fotografin: © Karoline Klimek

Bildrechte: © Hochschule Harz